编程客栈()5月30日 消息:当下,开源语言模型如雨后春笋般的冒出,其中有部分号称性能比Meta、谷歌等大科技公司开发的产品更优秀。

最近,一款名为FalconLM 开源语言模型就号称提供了比 Meta 的 LLaMA 更好的性能,也可以用于商业。但如果收入超过100万美元,则商业用途需要缴纳特许权使用费。

据了解,Falc编程onLM 是由阿拉伯联合酋长国阿布扎比的技术创新研究所 (TII) 开发。该组织声称 FalconLM 是迄今为止最强大的开源语言模型。相比之下,FalconLM 最大的变体拥有400亿个参数,这明显小于Meta 的具有650亿个参数的 LLaMA编程客栈。

(资料图片)

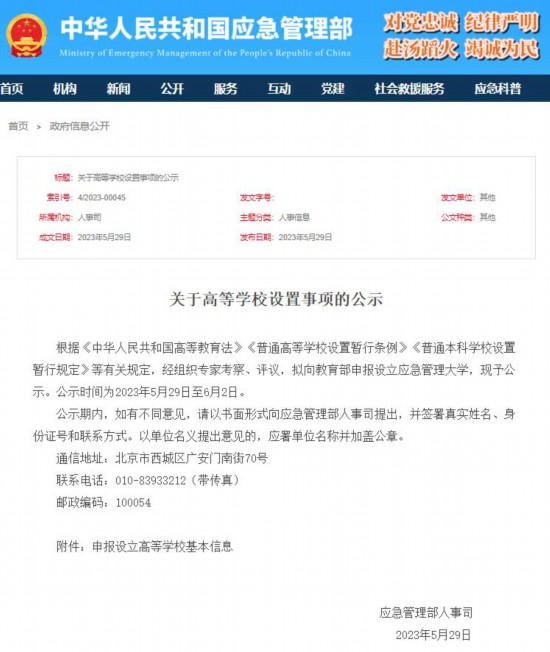

(资料图片)

在总结各种基准测试结果的Hugging Face OpenLLM 排行榜上,两个最大的 FalconLM 模型(其中一个已经用指令进行了改进)目前以显着优势占据前两名。

FalconLM 比 GPT-3训练成本更低效果更好

根据开发团队的说法,FalconLM 竞争优势的一个重要方面是训练数据的选择。语言模型在训练期间对数据质量很敏感。

研究团队开编程客栈发了一种从公共爬网数据集中提取高质量数据并删除重复数据的流程。在彻底清除重复数据GHYZh后,仍保留了5万亿条文本(token)——足以训练强大的语言模型。

FalconLM 接受了万亿token的训练。TII 还提到了针对性能和效率优化的架构,但没有提供详细信息。

据该团队称,优化的架构与高质量的数据集相结合,使得 FalconLM 在训练期间仅需要GPT-3的75% 的计算量,但明显优于旧的 OpenAI 模型。据说推理成本是 GPT-3的五分之一。

TII 的 FalconLM 用例包括文本生成、解决复杂问题、将模型用作个人聊天机器人,或用于客户服务或翻译等商业领域。

在商业应用中,TII 希望商业使用场景下,使用该语言模型获得100万美元收入后,将收取收入GHYZh的10% 作为版税,而对于个人使用和研究,FalconLM 是免费的。

FalconLM 模型的所有版本均可从 Huggingface 免费下载,网址:https://huggingface.co/tiiuae。

除了这些模型,该团队还在Apache2.0许可下以开源形式发布了包含6000亿个文本token的“Refinedweb”数据集的一部分。据说该数据集已准备好进行多模式扩展,因为示例已经包含图像的链接和替代文本。网址:https://huggingface.co/datasets/tiiuae/falcon-refinedweb